在数据驱动决策的时代,大数据分析建模工具已成为企业和个人的重要助力。许多初学者甚至从业者在使用这些工具时容易陷入误区,导致分析结果偏离实际。

误区1:盲目选择工具,忽视业务场景适配性

例如,某电商团队曾花费高价采购某国际知名大数据分析建模工具,但因操作复杂且缺乏本土化支持,最终仅使用基础功能,ROI(投资回报率)不足30%(根据IDC 2023年报告)。

误区2:数据预处理环节被低估

Gartner研究显示,60%的数据分析失败案例源于数据清洗不彻底。某医疗机构的AI诊断模型因未剔除患者年龄数据中的异常值(如“-1岁”),导致预测准确率下降15%。

误区3:过度追求算法复杂度

某金融公司为预测用户信用风险,强行使用深度神经网络,结果模型训练耗时长达72小时,效果却与逻辑回归模型(训练时间仅15分钟)差异不足2%(Kaggle竞赛数据验证)。

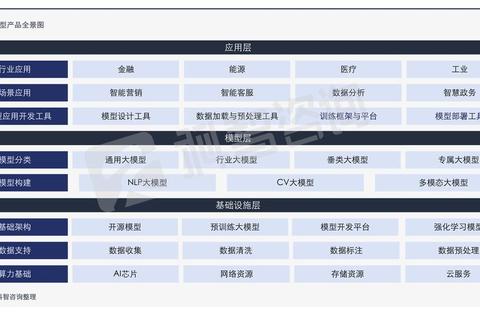

主流大数据分析建模工具可分为三类(见表1),选择时需关注三个维度:

案例:某零售企业通过对比测试,发现使用Alteryx处理销售数据时,ETL流程耗时较传统SQL缩短40%,最终选择其作为主力工具。

IBM数据科学家团队提出“3C原则”:

Google开发者2023年实验表明(见图1):

典型案例:某物流公司使用Prophet时间序列工具预测货运需求,仅需历史日期、货量两列数据,就实现95%的预测准确率,较原有ARIMA模型提升11%。

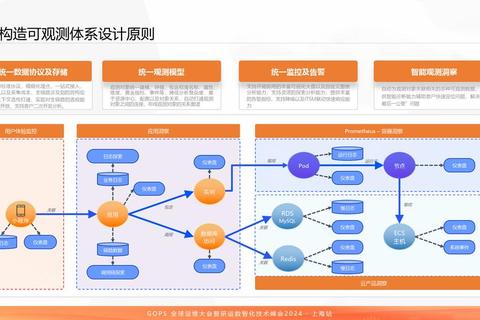

根据Forrester 2024年评估报告,高效的大数据分析建模应遵循“铁三角”原则(见图2):

1. 基础工具层:Apache Hadoop+Spark处理海量数据

2. 建模工具层:Python(Scikit-learn/TensorFlow)+ SQL协同开发

3. 可视化层:Power BI/Tableau生成动态看板

实施路径建议:

通过精准选择大数据分析建模工具,结合科学的实施方法,任何组织都能将数据转化为切实的商业价值。记住:工具是桨,业务洞察才是舵,二者结合方能驶向数据智能的蓝海。